Structure et dynamique des Réseaux multi-niveaux

Structure et dynamique des réseaux multi-niveaux

Contributeurs (ordre alphabétique) :

2017 : Rémy Cazabet, David Chavalarias, Guillaume Deffuant, Jean-Loup Guillaume, Laura Hernandez, Emmanuel Lazega

2011 : Jean-Baptiste Rouquier (rapporteur), Cyril Bertelle, Jean-Philippe Cointet, Jean-Pierre Gaudin, Matthieu Latapy, Damien Olivier, Lionel Tabourier

Keywords

Complex networks, Metrology, Hierarchical clustering, Communities, Graphs, Dynamics, Robustness, Partial data, Contextual data, Diffusion processes.

Concepts-clé :

réseaux multi-couches ou réseau de réseaux : réseaux constitués de plusieurs couches, chaque couche étant constituée d’entités appartenant à la même catégorie d’objets (ex. personnes, institutions, gènes, proteines, etc.). Les liens au sein d’une couche sont de même nature (ex. liens d’amitié, de co-auteur, etc.) et il peut y avoir des liens entre éléments de couches différentes (une personne appartient à une institution, une même personne est caractérisée par divers type de liens dans les différentes couches avec d’autres personnes : amitiés, travail, famille).

Réseau multi-niveaux : réseaux multi-couches où les objets d’une couche prennent part à la définition des objets de la couche supérieure (les cellules/les organes, les personnes/les institutions, etc.).

Réseau multiplex : réseau multi-couches où chaque couche comporte les mêmes nœuds mais les liens sont différents d’une couche à l’autre, exprimant différents types de liens (ex : liens d’amitiés, professionnels, familiaux).

Introduction

Les réseaux complexes sont un outil incontournable pour la modélisation des systèmes complexes à chaque fois que les interactions entre les éléments du système étudié doivent être prises en compte dans leur multitude et leur diversité.

Concept mathématique abstrait pour lequel il existe déjà un corpus de métriques et modèles rendant compte des propriétés locales et globales, la modélisation par réseaux ou graphes fournit aussi un cadre pour la modélisation de systèmes appartenant à des disciplines très diverses, tant théoriques que basées sur les données.

Initié au 20ème siècle par des disciplines telles que la sociologie (Moreno, 1934; White 1970), l’anthropologie (Mitchell, 1969), la géographie (ref), l’écologie [May1972] ou la génétique théorique (Kauffman & McCulloch 1967), l’approche de modélisation réseaux a connu en quelques années un essor considérable, grâce notamment à l’avènement des masses de données accessibles par les réseaux sociaux informatiques. Elle apporte un éclairage complémentaire aux analyses spécialisées propres aux disciplines traditionnelles.

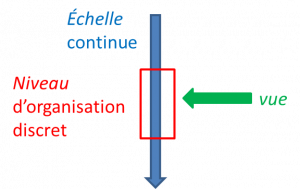

L’analyse de la structure des réseaux complexes et de leurs dynamiques donnent le moyen de représenter l’articulation multi-échelle (associée aux propriétés qui se manifestent lorsqu’on observe le système aux échelles différentes, en agrégeant des éléments, par exemple) qui caractérise la plupart des systèmes complexes, en mettant en avant des interactions situées et les positions structurelles de certains éléments du réseau ainsi que leur rôle dans la transformation du réseau. Cela permet aussi une analyse multi-niveau, qui souvent inclut la notion d’agrégation, mais qui intègre additionnellement les notions de fonction et organisation spécifique du niveau supérieur.

Quels sont les verrous actuels de l’étude des réseaux ? Quelles sont les problématiques communes à plusieurs disciplines ? Au fil des pages de la feuille de route, les réseaux sont mentionnés plusieurs fois. Le but est ici de décrire les avancées récentes, de montrer comment la théorie des réseaux donne un éclairage nouveau aux problèmes des diverses disciplines et d’identifier les axes de développement futur et les questions ouvertes.

Une approche transversale aux disciplines

Les progrès théoriques des deux dernières décennies ont été spectaculaires et souvent motivés par des applications pratiques, comme par exemple, la caractérisation de très grands réseaux particuliers (ex. Twitter, le web, le protéome, etc.). En conséquence, il existe un corpus assez complet pour décrire les différentes structures, locales et globales, des réseaux simples (où tous les noeuds et liens sont de la même classe). Ces travaux ont été étendus pour caractériser différent types de réseaux : les réseaux pondérés (liens ayant des poids différents), ou avec de la sémantique (contenu textuel, opinion, etc.) associée aux liens, les réseaux où il y a différent types de noeuds avec des liens connectant seulement des noeuds de type différent (réseaux bi ou multi-partis) [Newmann2010, Albert,Barabasi1999, Bocaletti et al..2006], ou encore les hyper-réseaux, dans lesquels les liens relient des groupes de noeuds (réseaux non diadiques). Les processus dynamiques ayant lieu dans ce type des réseaux, les modèles de diffusion sur réseaux ainsi que la dynamique de formation du réseau lui même ont aussi été largement étudiés cette dernière décennie [Barrat et al.2008].

Récemment plusieurs évolutions ont eu lieu, introduisant des nouveaux concepts qui ouvrent la voie à des applications nouvelles ou à des changement d’approche des anciens problèmes, apportant un nouvel éclairage. C’est le cas de la théorie des réseaux spatiaux , qui sont des réseaux plongés dans l’espace réel (souvent bi-dimensionnelle) de telle sorte que la distance entre nœuds du réseau est définie en tenant compte de la métrique spatiale [Barthélemy 2011] , ce type des réseaux permet des applications fructueuses dans les problèmes de transport et urbanisme.

Un saut qualitatif dans la description des divers systèmes, est la notion de réseau de réseaux ou réseaux multicouches. Dans cet approche chaque couche est un réseau avec ses liens intra-couche qui sont à la fois couplées par des interactions inter-couche. Ainsi les processus ayant lieu sur une couche peuvent affecter dramatiquement la dynamique des autres, comme c’est le cas par exemple dans le couplage entre le réseau informatique et le réseau électrique [Buldyrev et al. 2010].

Un cas particulier de réseau multi-couches pour lequel la théorie générale est déjà bien avancée est celui des multiplexes. Dans ces réseaux chaque couche comporte les mêmes nœuds mais les liens sont différents d’une couche à l’autre, le couplage entre couches est dit “parallèle”, matérialisé simplement par le fait que si l’état d’un nœud change dans une couche, ce changement est transmis aux autres. Ce type est très utile pour modéliser une société où les nœuds représentent les individus et chaque couche modélise les liens entre ces individus dans leurs différents espaces de la société (famille, travail, ville…) [Kivelä et al.].

La disponibilité de nouveaux jeux de données temporels a stimulé le développement de nouvelles méthodes d’analyse des réseaux dynamiques. De plus en plus de travaux sur les systèmes complexes cherchent ainsi à caractériser la dynamique de l’articulation entre le niveau local et global. Celle-ci dépend de la nature des relations entre les entités qui les composent, ce qui oriente la méthodologie adoptée.

Dans le cas où ces relations sont de l’ordre d’une intensité de co-présence (ex. co-occurrence de termes dans la littérature scientifique, co-activation de protéines, etc.) des méthodes de suivi d’évolution de communautés ont été proposées (Palla et al. 2005, Aynaud et al. 2013) et développées dans plusieurs domaines d’application comme par exemple les groupes sociaux (Palla et al. 2007) ou la scientométrie (Chavalarias & Cointet 2013). Dans ce cas, les réseaux dynamiques sont pensés comme une extension des réseaux statiques, chaque instant de l’évolution du réseau correspondant à un réseau statique pouvant être étudié avec les outils classiques de l’analyse de réseaux. Dans ce contexte, les liens du réseau correspondent à des relations, persistantes dans le temps.

Certains types de données issues du web et des dispositifs sociotechniques (ex. réseaux sociaux) a conduit à s’intéresser à des données de type interactionnelles. Dans ce contexte, les relations entre entités sont instantanées (ou de durée très courte par rapport à la période d’étude). Dans ce cas, la notion de réseau à un instant donné n’est généralement pas pertinente et les formalismes et méthodes définis sur les réseaux statiques ne sont pas trivialement généralisables. De nouveaux formalismes et de nouvelles approches ont été développés pour travailler sur ce nouveau type d’objets (temporal networks, flots de liens, time varying networks, etc.) [Gauvin et al.2014].

La modélisation par réseaux complexes a ainsi connu un engouement considérable au sein de la communauté scientifique avec plusieurs applications notoires ces dernières années dans des domaines aussi variés que l’épidémiologie, la sociologie, l’économie, la biologie (voir les exemple en annexe de ce chapitre), certaines méthodes proposées ces dernières années étant devenues des standards de l’analyse de données.

2. Grandes questions et défis

2.1 Incomplétude des données

La non-exhaustivité des données peut provenir de différents facteurs : coût de rassemblement, soucis de confidentialité, stratégie de rétention des possesseurs de données (capitalisation de l’information). Une partie de ce défi peut être aujourd’hui surmontée par des protocoles innovants de collecte de données. Notamment, l’obstacle des coûts ou de faisabilité peut être réduit par le recours à des protocoles qui s’appuient sur des dispositifs d’information embarqués, comme les téléphones portables, les dispositifs munis de puces RFID (type navigo/oyster), des logiciels proposés à l’utilisateur, etc.

Ces difficultés sont encore augmentées lorsque l’on souhaite faire un recueil longitudinal (encore appelé dynamique, ou diachronique) de données. La dynamique est par exemple cruciale pour étudier un réseau de déplacement de population (qui montre des cycles journaliers et saisonniers) et sa réaction aux incidents, ou bien l’infrastructure internet (le réseau de routeurs et serveurs) dont la dynamique est plus rapide que le processus de mesure.

Ces difficultés de collecte peuvent induire une description lacunaire des réseaux. Plusieurs voies existent pour travailler avec des données lacunaires :

utiliser des modèles artificiels pour compléter les trous ;

s’appuyer sur d’autres sources pour combler les manques (par exemple, utiliser des méthodes statistiques et démographiques pour estimer les données manquantes)

prendre en compte, dès la mesure, un indicateur de confiance sur toutes les données (par exemple la probabilité qu’un lien dans les données existe réellement dans le système mesuré, ou bien un intervalle de confiance sur le poids d’un nœud). Puis adapter les méthodes à ce type de données.

2.2 Méthodes contrôlées de changement d’échelle dans les réseaux.

Pour des modèles basés sur les données, comme dans l’étude des phénomènes de contagion, on doit souvent faire appel aux données issues de sources très diverses avec des structures et résolutions très différentes, il est alors nécessaire de développer un formalisme contrôlé permettant d’identifier des échelles d’agrégation intermédiaires qui soient à la fois optimales pour décrire le phénomène, tout en restant tractables mathématiquement ou numériquement, et qui permettent l’identification des interactions dominantes, responsables des régularités observées. De la même façon pour les très grands réseaux, il est nécessaire de trouver des mécanismes d’agrégation itératifs contrôlés qui pourraient s’inspirer de la renormalisation en Physique, où à chaque étape on intègre les informations aux petites échelles (par rapport à la taille caractéristique du système) en diminuant les degrés de liberté via une transformation du modèle.

2.3 Structure et hiérarchie

Morphogenèse du réseau

Plusieurs modèles de réseaux ont été développés en parallèle, permettant de capturer différentes propriétés structurelles des réseaux (cœur/périphérie, block model, communautés, homophilie/hétérophilie, embedding, etc.). Ils se basent sur des hypothèses concernant les principes générateurs de nouvelles connexions au niveau micro. Cependant, la plupart de ces travaux partent du principe que les noeuds du réseaux sont homogènes dans leur manière de créer des connections aux autres noeuds du réseau. Cette hypothèse d’homogénéité n’est pas vérifiée dans de nombreux systèmes naturels et artificiels, notamment en sciences sociales ou en écologie. Un des enjeux futurs de la modélisation des réseaux complexes est donc d’arriver à modéliser la relation entre hétérogénéité au niveau micro des processus de formation des liens et structure globale.

Structures hiérarchiques

La hiérarchie peut signifier simplement un ordre d’importance entre les nœuds. Ordonner les nœuds permet d’accorder plus d’importance à certains noeuds afin de les protéger (vaccination, sécurité, renforcement), les contrôler et surveiller, ou les mesurer. En théorie des réseaux il s’agit en général, d’une caractérisation topologique.

Mais de façon plus importante, parler de hiérarchie c’est parler de structures et sous-structures telles qu’elles peuvent être identifiées par des dendrogrammes ou des algorithmes de détection de communautés hiérarchiques. Comprendre cette organisation multi-échelles est crucial pour comprendre à la fois comment les structures à grande échelle émergent à partir des interactions locales (de bas en haut) et réciproquement comment comment la structure globales influe sur les entités locales.

Beaucoup de méthodes fructueuses pour hiérarchiser les noeuds ou détecter des structures dans un réseau sont déjà bien intégrés dans la communauté et diffusés dans les divers domaines applicatifs: petit mondes et navigabilité, mesures de centralité, détection de communautés (cf. “Community detection in graphs”, Santo Fortunato, 2010). Il est maintenant nécessaire de revisiter ces questions dans deux directions, d’une part pour les réseaux dynamiques, il faut comprendre comment la dynamique affecte la restructuration des communautés et d’autre part, les outils de hiérarchisation des noeuds ou des groupes des noeuds doivent être adaptés aux réseaux multicouches en général.

2.4 Mesures et caractérisation des réseaux dynamiques

La dynamique des réseaux peut s’exprimer de différentes façons non nécessairement exclusives :

la dynamique dans les réseaux et sous-réseaux telle que la variation des flux portés par la connectivité du réseau,

la dynamique des réseaux eux-mêmes, correspondant à la variation de la topologie/structure du réseau.

l’évolution des noeuds du réseaux lorsque ceux-ci sont des entités elles-mêmes complexes (ex. individus, cellules, etc.)

Dans certains cas, il y a coévolution entre les noeuds et les liens qu’ils forment entre eux, c’est-à-dire un mécanisme de différenciation interindividuelle concomitante à la formation du réseau (individus, cellules).

Mesure de la dynamique

Il s’agit ici de pouvoir étudier et qualifier la trajectoire de l’évolution du réseau, avec la mise en évidence de certains comportements caractéristiques tels que des dynamiques lentes ou rapides ou encore des phénomènes de bifurcations.

L’inscription de cette dynamique dans le réseau conduit à des constructions morphologiques. L’étude de ce phénomène peut s’effectuer sous différents angles :

la genèse de l’apparition de ces formes (aspect stigmergique du processus : lien important entre la forme en construction et la dynamique),

la détection de formes localisées dans le réseau (réseaux sociaux, …) et la dynamique des processus d’auto-organisation qui en sont à l’origine,

La mesure de l’influence du réseau global sur les processus émergents locaux.

Ces différents éléments amènent des questions telles que :

le réseau conserve-t-il les mêmes caractéristiques au cours de sa constitution ?

existe-t-il des étapes structurelles au cours de sa dynamique ?

Avec quelle granularité caractériser la dynamique ? stabilité des structures, des rôles, des positions, etc. (échelle trop fine : instable. échelle trop large: perte d’information.)

Propriétés et maîtrise du réseau dans sa dynamique

La manipulation des grands réseaux en tant qu’outils de modélisation appelle à identifier des propriétés et des méthodes de contrôle ou de régulation.

On peut s’intéresser à l’expression de lois de conservation sur les réseaux en tant que structures discrètes et notamment transposer ces lois de manière opératoire sur des très grands réseaux. A l’opposé, on peut être amené à modéliser des effets dissipatifs.

Étudier la dynamique, c’est implicitement étudier la robustesse et la résilience. Comment des perturbations introduites sur le réseau modifient les trajectoires de diffusion ?

Enfin, un problème important est celui du contrôle des trajectoires par des actions locales sur le réseau, et des dynamique multi-échelle. Comment une modification à une échelle donnée (par exemple au niveau méso : application d’une politique publique) se répercute sur les autres échelles ?

Dynamiques multi-niveaux

Alors que l’analyse de la dynamique des réseaux est devenue un domaine très dynamique, les développements futurs devront prendre en compte le fait que le formalisme de la modélisation réseaux s’est développé principalement sur une approche strictement relationnelle (et homogène en termes de noeuds). Celui-ci doit être adapté de manière à s’approcher des systèmes réels aux structures plus complexes qui sont composé de plusieurs sous-réseaux en co-évolution : les réseaux multi-couches (dont multi-niveaux et multiplex).

Par exemple en sociologie, un des enjeux est de comprendre l’articulation du niveau méso et macro qui constitue une caractérisation importante l’institution, comment co-évoluent les comportements et des structures. Il serait alors envisageable d’étendre les formalismes statistiques à la Snijders au multi-niveau pour constituer une base pour de nouveaux modèles de coévolution des niveaux.

Ce type d’approche ouvrira de nouvelles perspectives sur l’analyse des mobilités (trajectoires individuelles) au sein de structures multi-niveau.

Coevolution noeuds/topologie

Dans plusieurs domaines, les réseaux complexes sont utilisés pour modéliser des interactions entre entités qui sont elles-même complexes et sont dotées de capacités d’évolution, y compris dans leur manière de constituer de nouveaux liens ou d’en supprimer. Ceci introduit un bouclage entre morphogenèse d’un réseau et différenciation des types de noeuds.

Dans ce cas, les nœuds du réseau sont caractérisés par un ensemble de variables qui décrivent son type, ses capacités à modifier son réseau local et les possibilités d’évolution du type lui-même en fonction de son environnement. On appelle ce type de dynamique co-évolution des nœuds et des liens. Ce couplage est nécessaire pour modéliser des situations dans lesquelles les temps caractéristiques de la dynamique des nœuds et de l’évolution topologique sont comparables comme par exemple dans le cas des dynamiques culturelle (ex. dynamique d’opinions, Gracia-Lázaro et al. 2004 ; dynamique de préférences – Chavalarias 2006).

L’un des enjeux des prochaines années consistera à comprendre ce lien entre les structures du réseau et les processus de différenciation des nœuds. La validation de ces modèles pourra tirer partie des nouvelles opportunités offertes par les masses de données issues du web (co-évolution des réseaux de chercheurs, co-évolution des réseaux sociaux, etc.) ou des nouveaux protocoles d’expérimentation en ligne à grande échelle.

Plongement des réseaux (network embedding)

L’objectif du network embedding est de projeter des réseaux dans des espaces de dimension inférieure ce qui permet d’utiliser des méthodes classiques de fouille de données. Cependant, la projection doit pouvoir se faire de manière efficace et préserver des propriétés des réseaux originaux afin que les calculs effectués en dimension inférieure puissent être retransférés sur les réseaux.

Plusieurs résultats montrent que malgré la perte d’information liée à la projection, il est possible d’obtenir de meilleur résultats en dimension inférieure (par exemple pour la prédiction de lien ou la visualisation [Tang 2015]), ceci pouvant être lié au fait que la projection ne conserve que les facteurs dominants et élimine le bruit.

Les techniques simples préservent les proximités locales, deux sommets proches dans le réseau restent proches dans la projection, mais les techniques plus avancées essayent aussi de préserver des propriétés plus globales (par exemple, toutes les distances) ou complexes (par exemple, la structure communautaire).

3 Impacts societaux

La notion de réseaux s’est démocratisée en une décennie avec notamment l’avènement des réseaux sociaux. Même si ces nouvelles plateformes ne constituent en premier abord, qu’un

Les outils et méthodes de la science des réseaux sont déjà largement utilisés en dehors du monde académique, que ce soit par les acteurs du numérique (algorithmes de recommandation, PageRank), ou dans d’autres domaines (Ref ? Supply chain networks ?).

Le grand public est lui aussi de plus en plus souvent confronté aux réseaux complexes, en particulier par le biais de visualisations. Dans les médias d’une part, en complément aux représentations de type cartes ou graphiques comme support d’articles, en particulier dans le cadre du journalisme de données. Mais aussi à travers des plateformes et outils que cherchent à donner aux utilisateurs une meilleure vision, un meilleur contrôle de leurs données ou de leur position dans un réseau social, comme par exemple la plateforme de réseautage professionnel Linkedin, offrant une visualisation du réseau égo-centré à ses utilisateurs, ou indiquant la distance (degrés de séparation) dans le réseau entre l’utilisateur et les autres membres. Dans ce domaine une vulgarisation est nécessaire pour bien faire comprendre, par exemple comment la théorie des réseaux peut s’utiliser pour une exploitation automatique des données personnels ou même des métadonnées rendant les activités humaines traçables bien au delà des limites dont le public a conscience aujourd’hui.

Le champ des réseaux complexes pourra être amené à jouer dans le futur un rôle primordial dans la société, par sa capacité à faire face à des bouleversements, tels que la possible réorganisation de pans de la société suite à la désintermédiation, ou la démocratisation de nouvelles technologies de décentralisation des services comme les blockchains.

Le développement de macroscopes, plateformes et outils pour l’exploration et la compréhension de systèmes organisés complexes multi-niveaux (ex. Politoscope.org, Gargantext.org) qui ont été rendu possible par les récents développement des outils théoriques d’analyse des réseaux complexes, pourront être le moteur de changements sociétaux important, par la capacité qu’ils offrent aux acteurs de la société d’acquérir une vision de celle-ci, et de la place qu’ils occupent dans son organisation.

References

[RB2008] M. Rosvall, C.T. Bergstrom. Maps of random walks on complex networks reveal community structure. PNAS 2008 105 (4) 1118-1123.

[BGLL2008]VD Blondel, JL Guillaume, R Lambiotte, E Lefebvre. Fast unfolding of communities in large networks. Journal of Statistical Mechanics: Theory and Experiment 2008 (10), P10008.

[Fortunato2010] S Fortunato. Community detection in graphs. Physics reports, 2010, Elsevier.

Chavalarias, David (2006). ‘Metamimetic Games: Modeling Metadynamics in Social Cognition’. Journal of Artificial Societies and Social Simulation 9(2)5 <http://jasss.soc.surrey.ac.uk/9/2/5.html>.

Aynaud, T., Fleury, E., Guillaume, J. L., & Wang, Q. (2013). Communities in evolving networks: definitions, detection, and analysis techniques. In Dynamics On and Of Complex Networks, Volume 2 (pp. 159-200). Springer New York.

[May1972] Will a large complex system be stable? RM May, Nature, 238, 5364, p413-414,(1972)

[Newmann2010] Networks, an Introduction, Newmann M.J.E. Oxford University Press, 2010

[Albert,Barabasi1999]Statistical mechanics of complex networks. R Albert, AL Barabasi, Rev. of Mod. Phys. 74, 47-97 (1999).

[Bocaletti et al.2006] Complex Networks: Structure and Dynamics S. Boccaletti, V. Latora, Y. Moreno, M. Chavez, D.U. Hwang. “”, Physics Reports 42 4(2006), pp 175-308

[Barrat et al.2008] Dynamical processes on complex networks, A Barrat, M Barthelemy, A Vespignani, Cambridge University Press, 2008.

[Colizza et al. 2006] The role of the airline transportation network in the prediction and predictability of global epidemics. Vittoria Colizza, Alain Barrat, Marc Barthélemy, Alessandro Vespignani, PNAS

103, Numéro 7, Pages 2015-2020;

[Pastor-Satorras, Vespignani 2001) Epidemic spreading in scale-free networks

R Pastor-Satorras, A Vespignani, Phys.Rev.Lett. 86 (14), 3200

[Barthélemy 2011] Spatial networks, M. Barthélemy. Physics Reports, Vol.499, Issues 1–3, Pages 1-102 (February 2011).

[Buldyrev et al. 2010] Catastrophic cascade of failures in interdependent networks

SV Buldyrev, R Parshani, G Paul, HE Stanley, S Havlin – Nature, 464, 7291,p1025-1028 (2010).

[Kivelä et al.] Multilayer networks, Mikko Kivelä, Alex Arenas, Marc Barthelemy, James P. Gleeson, Yamir Moreno, Mason A. Porter, J Complex Netw (2014) 2 (3): 203-271.

DOI:https://doi.org/10.1093/comnet/cnu016

[Gauvin et al. 2014] Detecting the community structure and activity patterns of temporal networks: a non-negative tensor factorization approach, L. Gauvin, A. Panisson, C. Cattuto

PLoS ONE 9(1), e86028 (2014)

[Menezes & Roth 2014] Menezes, T., Roth, C., 2015. Symbolic regression of generative network models. Scientific Reports 4. doi:10.1038/srep06284

[Hausmann et al.] The Atlas of Economic Complexity, Mapping Paths to Prosperity

Ricardo Hausmann, César A. Hidalgo, Sebastián Bustos, Michele Coscia, Alexander Simoes and Muhammed A. Yildirim, The MIT Press (2014). https://www.hks.harvard.edu/centers/cid/publications/books/atlas

[Gracia Lázaro, et al.] Coevolutionary network approach to cultural dynamics controlled by intolerance. Carlos Gracia-Lázaro, Fernando Quijandría, Laura Hernández, Luis Mario Floría, and Yamir Moreno, Phys.Rev. E 84, 067101 (2011)

Brailly, J. (2016), Dynamics of networks in trade fairs—A multilevel relational approach to the cooperation among competitors, Journal of Economic Geography, 16: 1279–1301

Brailly, J. and Lazega, E., 2012. Diversité des approches de la modélisation multiniveaux en analyses de réseaux sociaux et organisationnels. Mathématiques et Sciences Sociales 198, 5-32

Breiger, R. L. (1974), “The Duality of Persons and Groups”, Social Forces, 53: 181-190

Chavalarias, D., Cointet, J.-P., 2013. Phylomemetic patterns in science evolution—the rise and fall of scientific fields. PloS one 8, e54847.

Fararo, T. J. and Doreian, P. (1980), Tripartite structural analysis: generalizing the Breiger Wilson formalism, Social Networks, 6:141-175.

Anna Goldenberg, Alice X. Zheng, Stephen E. Fienberg and Edoardo M. Airoldi, “A Survey of Statistical Network Models”, 2009

Grossetti, Michel, 2011, « L’espace à trois dimensions des phénomènes sociaux. Echelles d’action et d’analyse », SociologieS, http://sociologies.revues.org/index3466.html

Santo Fortunato, “Community detection in graphs”, 2010

- da F. Costa, F. A. Rodrigues, G. Travieso and P. R. Villas Boas, “Characterization of Complex Networks: A Survey of measurements”, Advances in Physics 57, 2007

Lazega, E., Jourda, M.-Th., Mounier, L. & Stofer, R. (2008), “Catching up with big fish in the big pond? Multi-level network analysis through linked design”, Social Networks, 30:157-176.

Lazega, E., Mounier, L., Snijders, T.A.B. & Tubaro, P. (2012), “Norms, status and the dynamics of advice networks”, Social Networks, 34:323-332

Lazega, E., S.Sapulete, L.Mounier (2011), “Structural stability regardless of membership turnover? The added value of blockmodelling in the analysis of network evolution”, Quality & Quantity, 45:129-144

Snijders, T. A. B. (1996), Stochastic Actor-Oriented Models for Network Change, Journal of Mathematical Sociology, 21, 149-172.

Snijders, T. A. B. (2005). “Models for Longitudinal Network Data”. Chapter 11 in Peter Carrington, John Scott and Stanley Wasserman (eds.). Models and Methods in Social Network Analysis. New York: Cambridge University Press.

Snijders, Tom A.B. (2016). The Multiple Flavours of Multilevel Issues for Networks. In Lazega, E. and Tom A.B. Snijders (eds.), Multilevel Network Analysis for the Social Sciences, Cham: Springer, p. 15-46.

Mitchell, J. C. (Ed.). (1969). Social networks in urban situations: Analyses of personal relationships in Central African towns. Manchester University Press.

Moreno, J. L., & Jennings, H. H. (1934). Who shall survive? (Vol. 58). Washington, DC: Nervous and mental disease publishing company.

Tang, Jian, et al. “Line: Large-scale information network embedding.” Proceedings of the 24th International Conference on World Wide Web. ACM, 2015.

Wang, P., Robins, G., Pattison, P., & Lazega, E. (2013). Exponential random graph models for multilevel networks. Social Networks 35(1), 96-115.

Wasserman, S. & Iacobucci, D. (1991). “Statistical modeling of one-mode and two-mode networks: Simultaneous analysis of graphs and bipartite graphs.” British Journal of Mathematical and Statistical Psychology, 44, 13–44.

White, H. C. (1970), Chains of Opportunity : System Models of Mobility in Organizations, Cambridge, ma, Harvard University Press.

Annexe : exemples des réussite de l’application de la théorie des réseaux

Sans être exhaustifs, voici quelques exemples de développements illustrant des avancées théoriques et méthodologiques récentes.

Emergence de nouveaux outils pour la sphère académique, industrielle et citoyenne

L’analyse des réseaux est en train de changer les pratiques dans un grand nombre de domaines : éducation, management, santé, etc.

A développer : mentionner la diffusion d’outils tels que Gephi, Cortext, Gargantext, Sci², etc.)

Modeles épidémiologiques et prescriptions de politiques de santé

L’adoption des modèles de réseau pour décrire les interactions entre les individus a permis d’important progrès dans la compréhension des mécanismes de propagation d’épidémies. Après l’étude des modèles théoriques de diffusion sur des réseaux ayant différentes topologies (Vespignani2001), des modèles épidémiologiques ont intégré des réseaux de transport modernes pour décrire la diffusion des épidémies à large échelle. En particulier, un modèle épidémiologique stochastique intégrant la base de donnée de l’Association Internationale de Transport Aérien (IATA) et un recensement de population a permis de déterminer le rôle du réseau aérien dans le pattern de diffusion des maladies émergentes. La pertinence de ces scénarios prédictifs a été évaluée par une analyse a posteriori de cas réels (Colizza et al. 2006).

Réseaux et controverses : de l’effet des normes sur la dynamique des structures

Dans une enquête sur le fonctionnement du Tribunal de Commerce de Paris, une institution judiciaire consulaire, dont les juges sont des hommes et des femmes d’affaires, les sociologues observent les effets d’une controverse normative sur l’évolution, au sein de l’organisation, du turnover relationnel entre les juges et sur la structure relationnelle qui en résulte. Les données empiriques issues d’une enquête en longitudinal (mesures en 2000, 2002 et 2005) concernent 228 juges interviewés sur leurs relations de conseil à l’intérieur du tribunal et sur leur raisonnement et manière de prendre des décisions de justice, en particulier sur leur degré de punitivité dans des affaires de concurrence déloyale et d’attribution de dommages et intérêts. Une dynamique cyclique de centralisation – décentralisation – recentralisation du réseau est d’abord mise en évidence et expliquée (Lazega, Sapulete et Mounier, 2011). Des hypothèses sont ensuite testées sur l’effet des normes sur l’évolution de la structure et sur la dynamique de l’apprentissage intra-institutionnel (Lazega, Mounier, Snijders et Tubaro, 2009) à l’aide du formalisme du modèle Siena (Snijders, 2001, 2005). Les résultats suggèrent que les normes sociales peuvent exercer des effets différenciés sur les comportements, mais seulement au travers d’effets intermédiaires de la hiérarchie des statuts sociaux. D’une manière générale, le simple fait de partager les mêmes normes de punitivité n’est pas suffisant pour rapprocher les acteurs sociaux. Cette approche de l’apprentissage par alignement épistémique et normatif dans les controverses procure donc des éléments nouveaux dans l’étude des relations entre normes, structure et comportement.

Dynamique des réseaux multiniveaux pour la coopération entre concurrents dans les foires commerciales

Les foires commerciales mobilisent plusieurs niveaux d’action collective, en particulier individuelles et organisationnelles. Cependant, le caractère multiniveau de ces événements est souvent trop simplifié ou ignoré dans la littérature. Julien Brailly (2016) modélise les réseaux à niveaux multiples au fil du temps à l’aide de modèles de graphiques aléatoires exponentiels à plusieurs niveaux pour explorer la manière dont la proximité temporelle entre les représentants des ventes lors des foires commerciales facilite la coopération entre concurrents. Sont mises ainsi en évidence des configurations relationnelles durables à plusieurs niveaux qui façonnent la structure économique d’une industrie et peuvent introduire des asymétries qui dépendent de la taille des entreprises. On démontre que ces asymétries contribuent à l’augmentation des inégalités socioéconomiques entre les acteurs du marché.

Détection de communautés dans le cas d’un partitionnement statique

L’une des propriétés les plus importantes des réseaux complexes est leur organisation en groupes, ou communautés, qui correspondent généralement à des groupes des noeuds ayant une connexion intragroupe plus importante qu’avec le reste du réseau. L’extraction automatique de tels groupes, ou détection de communautés, est un problème qui a été remis sur le devant de la scène au début des années 2000. Il peut se formaliser de différentes manières : partitionnement (une et une seule communauté par sommet) ou recouvrement (chaque sommet peut appartenir à plusieurs communautés), être étudié de manière locale ou globale, considérer des réseaux statiques ou dynamiques, simples ou multi-niveaux, etc. L’objectif est alors de proposer des algorithmes qui, étant donné un réseau, vont tenter d’en extraire les groupes les plus pertinents. Bien que de nombreux problèmes soient toujours ouverts, celui du partitionnement a connu plusieurs succès à la fin des années 2000 qui ont indiscutablement fait entrer certaines des méthodes proposées (ex. [BGLL2008] et Infomap [RB2008]) parmis les standards de l’analyse des réseaux. Celles-ci sont utilisées dans de très nombreux domaines [Fortunato2010] et logiciels (ex. NetworkX, Gephi, Tulip).

Complexité économique

La notion de réseau commence à percer en économie, où elle introduit un changement de paradigme. D’abord car cette notion permet le développement des modèles qui vont au delà de l’approche champ moyen dans lequel un “agent représentatif”, purement rationnel et disposant d’une information complète est supposé décrire le comportement du système. Ensuite cette approche permet de mettre en évidence la structure d’interaction entre les acteurs économiques, laissant apparaître des patterns caractéristiques. Un exemple de cette modification d’approche d’un problème économique est la modélisation du commerce international par un réseau biparti des pays producteurs et des produits qui permet une classification des économies des pays étudiés plus informative que celle basée sur le volume total des échanges de chaque pays. Cette approche donne une indication des pays ou régions ou des acquisitions et/ou innovations technologiques qui peuvent être espérées. (altas_complexity).